Mengetahui Bias Dalam AI dan Mitigasinya Agar Lebih Objektif

Firdaus Aulia Faza

∙15 March 2024

Kecerdasan Buatan (AI) telah menjadi tonggak revolusioner dalam perkembangan teknologi modern, menawarkan berbagai aplikasi yang membantu manusia dalam berbagai aspek kehidupan, mulai dari pengolahan data hingga pengambilan keputusan kompleks. Namun, di balik kemajuan yang luar biasa ini, terdapat isu yang semakin mendapat perhatian, yaitu bias dalam sistem kecerdasan buatan.

Apa itu Bias Dalam AI?

Dalam konteks umum, bias mengacu pada kecenderungan atau kecondongan yang menyebabkan penilaian atau keputusan tidak objektif atau tidak netral. Ini bisa terjadi dalam berbagai situasi, termasuk dalam pemikiran, persepsi, sikap, atau tindakan seseorang.

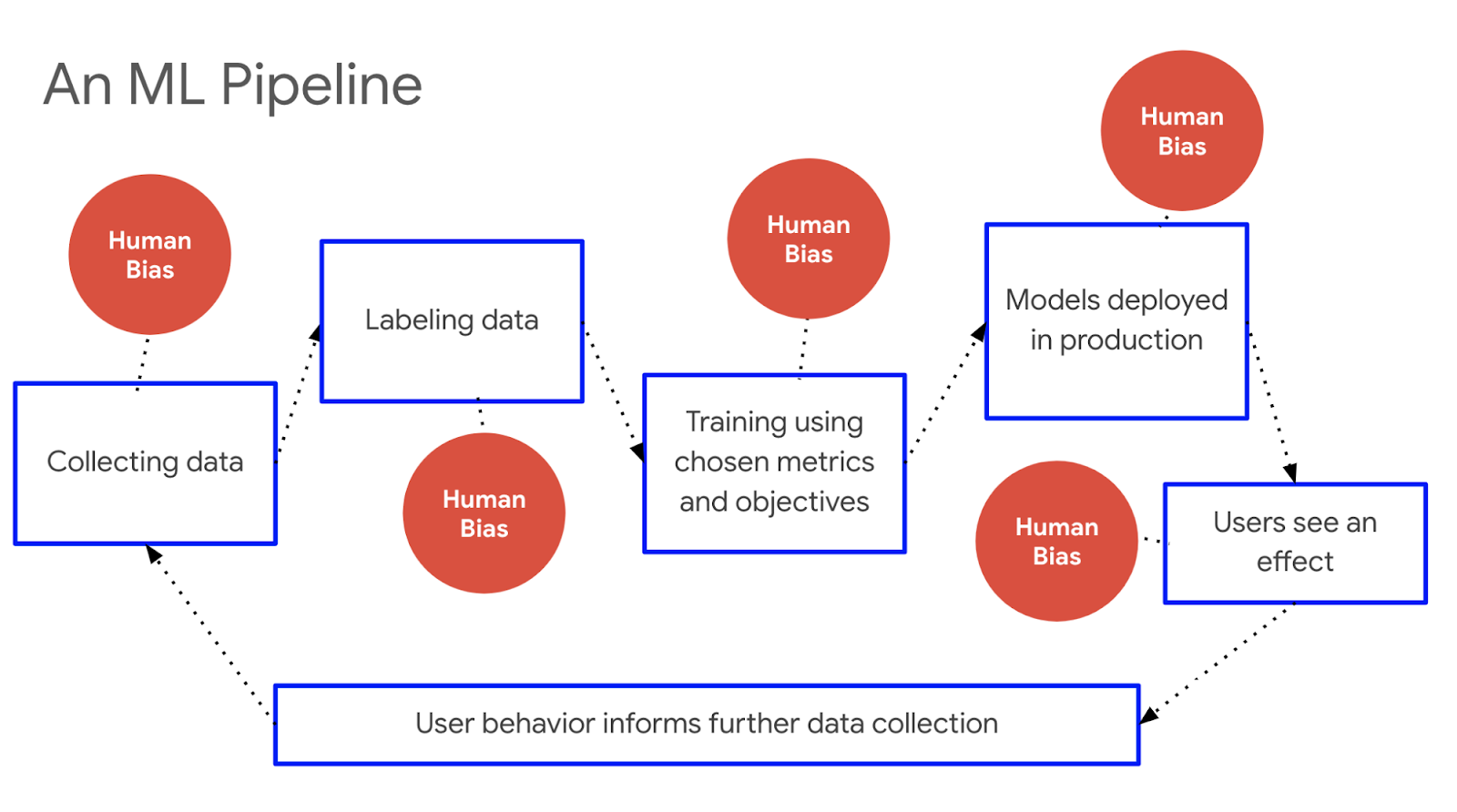

Bias dalam AI mengacu pada perlakuan sistematis dan tidak adil terhadap individu atau kelompok berdasarkan karakteristik mereka, seperti ras, gender, usia, atau disabilitas, oleh sistem kecerdasan buatan . Bias dapat terjadi pada berbagai tahapan dalam pipeline AI, termasuk pengumpulan data, pra-pemrosesan data, pemilihan model, dan keputusan pasca-pemrosesan.

Bias dalam AI mengacu pada perlakuan sistematis dan tidak adil terhadap individu atau kelompok berdasarkan karakteristik mereka, seperti ras, gender, usia, atau disabilitas, oleh sistem kecerdasan buatan . Bias dapat terjadi pada berbagai tahapan dalam pipeline AI, termasuk pengumpulan data, pra-pemrosesan data, pemilihan model, dan keputusan pasca-pemrosesan.

Contoh bias dalam data collection adalah saat resampling data banyak, seringkali data minoritas yang dikumpulkan. Hal ini menyebabkan kesimpulan yang kurang akurat tentang populasi tertentu, karena kelompok-kelompok yang kurang terwakili mungkin memberikan wawasan yang tidak tertangkap. Sebagai contoh, dalam sistem pengenalan wajah yang dilatih terutama menggunakan data wajah pria kulit putih yang lebih banyak, model-model tersebut cenderung memiliki tingkat akurasi yang lebih rendah ketika dihadapkan pada wajah perempuan atau individu dari latar belakang etnis yang berbeda.

Saat data labeling juga bisa terjadi bias. Bias label terjadi ketika label yang diterapkan pada data pelatihan tidak tepat atau mencerminkan pandangan subjektif atau prasangka manusia yang memberikannya. Hal ini dapat terjadi ketika label diberikan oleh manusia yang memiliki pandangan yang tidak netral atau terpengaruh oleh prasangka. Dalam menentukan metrik evaluasi model, bias dapat muncul jika kita memilih metrik yang tidak mencerminkan dengan baik tujuan yang sebenarnya dari aplikasi model tersebut.

Sebagai contoh, jika kita hanya memilih akurasi sebagai metrik evaluasI. Dalam model deployment contohnya adalah model AI yang digunakan untuk menilai aplikasi kredit dan memberikan keputusan secara otomatis tentang apakah sebuah pinjaman akan disetujui atau ditolak Dalam kasus ini, model AI dilatih menggunakan data historis tentang pengajuan kredit, termasuk informasi tentang pendapatan, riwayat kredit, status pekerjaan, dan faktor-faktor lainnya.

Namun, karena data latihan tersebut mungkin mencerminkan bias dalam penolakan kredit terhadap kelompok-kelompok tertentu (misalnya, minoritas rasial atau kelompok ekonomi rendah), model tersebut dapat mempelajari dan mereproduksi bias ini saat digunakan untuk pengambilan keputusan di lingkungan produksi.

Efek Negatif dari AI yang Bias

Diskriminasi dan Ketidakadilan:

Jika AI memiliki bias yang tidak adil terhadap kelompok tertentu, ini dapat menyebabkan diskriminasi sistematis dan ketidakadilan dalam pengambilan keputusan, seperti rekrutmen, penilaian kredit, atau sistem peradilan. Hal ini dapat memperkuat ketidaksetaraan sosial yang sudah ada.

Kesalahan dan Ketidakakuratan:

Jika AI mengandalkan data yang bias atau algoritma yang tidak tepat, ini dapat menghasilkan kesalahan dan ketidakakuratan dalam pengambilan keputusan. Hal ini dapat berdampak negatif dalam berbagai bidang, seperti diagnosis medis yang salah, penilaian kinerja yang tidak akurat, atau pengaturan harga yang tidak adil.

Contoh AI yang Bias Dalam dunia nyata

Pada 2015 google photo salah mengidentifikasi foto yang seharusnya dikelompokan sebagai orang malah di identifikasikan sebagai hewan. Dikarenakan kejadian tersebut google meminta maaf dan sampai saat ini google masih tidak bisa mengelompokan gorilla di google photo.

-

Studi Kasus 1: Bias Gender dalam Rekrutmen menggunakan AI (Buolamwini & Gebru, 2018) Studi "Gender Shades" yang dilakukan oleh Buolamwini dan Gebru (2018) mengungkapkan adanya bias gender dalam algoritma pengenalan wajah yang digunakan dalam proses rekrutmen menggunakan AI. Penelitian ini melibatkan analisis terhadap perusahaan teknologi besar yang menggunakan teknologi pengenalan wajah untuk mengidentifikasi gender dari foto pelamar kerja. Hasil Studi Studi ini menunjukkan adanya kesenjangan akurasi yang signifikan dalam pengenalan gender berdasarkan warna kulit dan jenis kelamin. Algoritma tersebut cenderung memberikan kesalahan pengenalan yang lebih sering pada wanita kulit hitam dibandingkan dengan laki-laki kulit putih. Ditemukan bahwa tingkat kesalahan pengenalan pada wanita kulit hitam mencapai lebih dari 30% dibandingkan dengan tingkat kesalahan di bawah 1% pada laki-laki kulit putih. Dampak Studi ini menyoroti dampak negatif dari bias gender dalam algoritma AI pada proses rekrutmen. Penggunaan algoritma yang tidak akurat dan bias dapat mengakibatkan diskriminasi terhadap pelamar kerja berdasarkan jenis kelamin dan ras. Hal ini memperkuat ketidaksetaraan kesempatan dan mencegah kelompok yang tertindas mendapatkan kesempatan yang setara dalam dunia kerja.

-

Studi Kasus 2: Ketidakadilan Rasial dalam Penentuan Hukuman oleh Algoritma AI (Dressel & Farid, 2018) Studi yang dilakukan oleh Dressel dan Farid (2018) melibatkan analisis algoritma AI yang digunakan dalam penentuan hukuman bagi narapidana dengan tujuan memprediksi risiko kejahatan berulang (recidivism). Penelitian ini bertujuan untuk memahami tingkat akurasi dan ketidakadilan yang mungkin terjadi dalam proses tersebut. Hasil Studi Studi ini menemukan bahwa algoritma yang digunakan untuk memprediksi recidivism memiliki tingkat kesalahan yang signifikan, dengan lebih dari 40% prediksi yang salah. Selain itu, algoritma tersebut juga menunjukkan ketidakadilan rasial, dengan tingkat kesalahan yang lebih tinggi untuk kelompok minoritas dibandingkan dengan kelompok mayoritas. Dampak Studi ini menunjukkan dampak serius dari ketidakadilan rasial dalam algoritma AI pada proses penentuan hukuman. Penggunaan algoritma yang tidak akurat dan bias dapat menghasilkan keputusan hukuman yang tidak adil, memperkuat kesenjangan rasial, dan mempengaruhi hidup individu dan komunitas secara negatif.

Mitigasi Bias dalam AI

Mengacu Pada buku yang ditulis oleh Genevieve Smith and Ishita Rustagi yang berjudul Mitigating Bias In Artificial Inteligence mengusulkan langkah langkah untuk mengurangi bias pada AI.

Pada buku ini memitigasi bias dibagi menjadi 3 yaitu dalam tim pembuat AI, Algoritma modelnya lalu pada Tata kelola perusahaan dan kepemimpinan.

-

Memungkinkan Keberagaman anggota Tim yang bekerja mengembangkan algoritma dan Sistem AI Memiliki beragam tim yang meneliti, mengembangkan, mengoperasionalkan dan mengelola algoritma dan Sistem AI sangat penting. Tim yang beragam tidak hanya berupa warna kulit akan tetapi bisa yang lain.. Keragaman mencakup individu dengan perbedaan karakteristik pribadi dan kelompok - seperti usia, kemampuan, orientasi seksual, dll.

-

Mempromosikan budaya etika dan tanggung jawab yang terkait dengan AI. Menciptakan budaya yang mengharapkan dan memberdayakan karyawan untuk memprioritaskan pertimbangan kesetaraan pada setiap langkah proses pengembangan algoritma. Sesuai dengan pemahaman bahwa menghilangkan sepenuhnya bias dalam AI tidak memungkinkan, Perusahaan harus menjaga standar kejelasan mengenai cara kerja model mereka, serta transparansi mengenai kelemahan atau risiko potensial.

-

Menerapkan pengembangan dataset yang bertanggung jawab Pastikan bahwa pengembangan dataset dilakukan dengan tanggung jawab, dengan adanya pemeriksaan dan standarisasi dalam membuat dataset baru maupun mengadaptasi yang sudah ada

-

Menetapkan kebijakan dan praktik untuk memungkinkan pengembangan algoritma yang bertanggung jawab. Membangun framework yang memeriksa dan secara aktif mengurangi bias pada setiap tahap proses pengembangan algoritma. Hal ini melibatkan memberikan kerangka kerja kepada tim yang memungkinkan mereka untuk memprioritaskan kesetaraan dalam menentukan tujuan algoritma mereka, memastikan dataset yang digunakan dikembangkan dan diberi label dengan bertanggung jawab, serta memastikan variabel-variabel tidak memberikan kerugian bagi komunitas tertentu.

-

Membentuk tata kelola perusahaan untuk AI yang bertanggung jawab dan kebijakan internal menyeluruh untuk mengurangi bias. Penting untuk membentuk tata kelola perusahaan untuk AI yang bertanggung jawab dan kebijakan dan pedoman internal yang menyeluruh untuk mengurangi bias. Struktur tata kelola etika AI adalah langkah awal yang penting. Praktik baik untuk tata kelola AI yang bertanggung jawab mencakup, misalnya: memupuk rasa tanggung jawab bersama, menilai dan memperbarui struktur insentif dan dinamika kekuasaan yang dapat menghambat individu untuk berbicara, dan mengkaji prioritas dan keterbatasan kepemimpinan.

-

Memanfaatkan CSR untuk memajukan AI yang bertanggung jawab Corporate Social Responsibility (CSR) adalah konsep di mana perusahaan mempertimbangkan dampak sosial dan lingkungan dari kegiatan bisnis mereka. Ini mencakup tanggung jawab perusahaan untuk memperhatikan dan mempengaruhi faktor-faktor sosial dan lingkungan dalam segala aspek operasional mereka, termasuk hubungan dengan karyawan, konsumen, komunitas lokal, lingkungan, dan masyarakat secara luas.

-

Gunakan suara dan pengaruh Anda untuk memajukan perubahan industri dan regulasi untuk AI yang bertanggung jawab. Seorang Leader yang bertanggung jawab memahami bahwa bias dalam AI bukanlah hanya masalah teknis dan melihat adanya pertukaran terkait "keadilan" yang bisa terjadi. Para pemimpin bisnis dapat menggunakan suara dan pengaruh mereka untuk mendukung perubahan industri dan memajukan regulasi yang sangat diperlukan.

Kesimpulan

Bias dalam kecerdasan buatan (AI) merupakan isu yang sangat penting dan kompleks yang memerlukan perhatian serius dari para pengembang, peneliti, dan pemimpin industri. Bias dalam AI dapat menyebabkan diskriminasi, ketidakadilan, kesalahan, dan ketidakakuratan dalam pengambilan keputusan, yang dapat memiliki dampak negatif yang signifikan pada individu, kelompok, dan masyarakat secara luas.

Dalam rangka mengatasi bias dalam AI, diperlukan pendekatan yang holistik dan terkoordinasi. Langkah-langkah seperti memanfaatkan keberagaman dalam tim pengembangan, menerapkan budaya etika dan tanggung jawab terkait AI, serta menggunakan pengembangan dataset yang bertanggung jawab dapat membantu mengurangi bias dalam AI. Selain itu, tata kelola perusahaan yang bertanggung jawab, kebijakan internal yang menyeluruh, serta pemanfaatan Corporate Social Responsibility (CSR) juga diperlukan untuk memajukan AI yang bertanggung jawab.

Selain itu, penting bagi para pemimpin bisnis atau leader untuk memahami peran mereka dalam mendukung perubahan industri dan regulasi yang diperlukan untuk mengatasi bias dalam AI. Dengan menggunakan suara dan pengaruh mereka, para pemimpin dapat memainkan peran penting dalam memperjuangkan AI yang lebih adil, transparan, dan bertanggung jawab.

Dengan mengambil langkah-langkah tersebut, diharapkan bahwa kita dapat mengurangi dampak negatif dari bias dalam AI dan menciptakan sistem kecerdasan buatan yang lebih inklusif, setara, dan dapat dipercaya untuk kebaikan semua orang.

bagikan

ARTIKEL TERKAIT